ABSTRACT

Human activity recognition (HAR) has been actively researched in fields such as healthcare to understand and analyze human behavior in human-robot interaction. However, most studies have struggled to recognize activities like turning and motion transitions, which are often associated with dynamic balance. Therefore, we propose a novel HAR approach using a single sensor to collect and early fuse motion and position data. The aim is to enhance the accuracy of motion classification for daily activities and those that cause imbalance, which have traditionally been difficult to recognize. We constructed a quarantine room environment for data collection and to evaluate the impact of the suggested features on behavior. Five deep learning models were trained and evaluated to identify the optimal model. The collected data was classified and analyzed by the selected model, which demonstrated an average accuracy of 98.96%.

-

KEYWORDS: Smart hospital, Smart home, Human activity recognition, Indoor positioning system, Ambient assisted living

-

KEYWORDS: 지능형 병원, 지능형 집, 사람 행동 인식, 실내 위치추적 시스템, 전천후 생활보조

1. 서론

인간 행동 인식은 행동 패턴을 이해하고 적절하게 대응하기 위해 다양한 분야에서 연구되고 있다. 인간-로봇 상호작용에서는 소셜 로봇과 인간 간의 소통을 위한 연구들이 진행되어왔다. 예를 들어, RGB 카메라를 이용해 로봇과 함께 식사하거나 게임을 하며 사용자의 상태를 파악하고 즉각적으로 대응하는 방법이 개발되었다[

1,

2].

돌봄 서비스 분야에서도 응급상황을 감지할 수 있도록 상황을 판단할 수 있는 로봇을 도입하기 위한 연구가 진행 중이다. 이를 통해 노약자나 환자를 효과적으로 모니터링하고, 특히 병원이 멀리 떨어져 있으며 인력이 부족한 지역에서 효과적으로 모니터링하고 환자를 돌볼 수 있다[

3]. 간호사나 의사가 항상 환자를 관찰하는 것은 어렵기 때문에 로봇은 문제가 발생했을 때 빠르게 인식하고 정보를 전달해야 한다. 이를 위해서 사람들이 일상 생활에서 흔히 하는 행동을 이해하고 낙상의 전조와 같은 비정상적이거나 위험한 행동을 감지하는 것이 필요하다.

예를 들어, 고령 환자나 거동이 불편한 환자는 낙상 위험이 더 높으며, 특히 앉았다 일어설 때[

4,

5] 또는 몸을 돌릴 때[

6,

7]와 같이 정적인 상태에서 갑작스러운 동적 변화를 겪을 때 주의가 필요하다. 이러한 동작들은

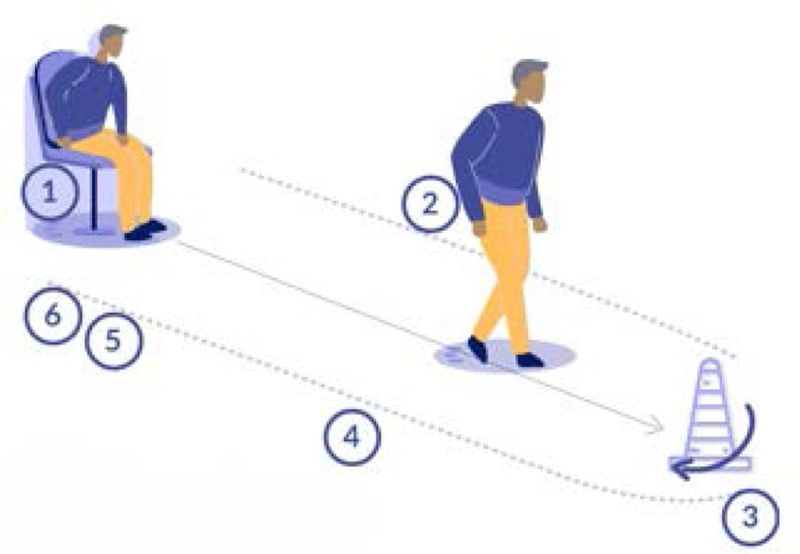

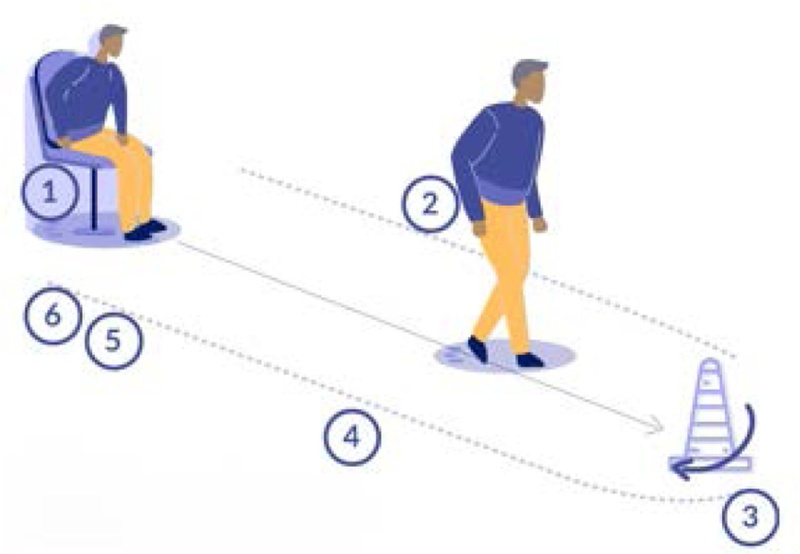

Fig. 1에 표시된 낙상 위험을 평가하는 데 사용되는 테스트인 Timed Up and Go Test (TUG)에서 사용되는 주요 동작이다[

8]. 이 테스트는 환자가 자리에서 일어나 목표 지점으로 돌아가는 데 걸리는 시간을 측정하여 낙상 위험과 필요한 주의 수준을 파악할 수 있는 기준을 제공한다.

Fig. 1 Timed up and go test

그러나 이러한 전환 동작들은 앉기, 눕기, 걷기와 같은 동작에 비해 수집이 어렵고, 전환 동작에 필요한 시간이 사람마다, 상황마다 다르기 때문에 일정한 크기의 데이터로 분류하기가 쉽지 않다. 따라서 공개된 HAR 데이터셋에는 이러한 전환 및 방향 전환 동작에 대한 데이터를 찾기 어렵다는 한계점이 있었다[

9]. 데이터 부족으로 인하여 딥러닝 모델을 사용하여 분류할 때 이러한 움직임은 종종 걷기와 같은 동적 동작으로 잘못 분류된다[

10]. 따라서 이러한 움직임에 대한 데이터셋을 수집하고 분류하는 것은 동작 전환 중에 발생할 수 있는 낙상과 같은 위험한 상황을 인식하는 데 중요하다. 그러나 이를 위해 카메라와 같은 시각 센서를 사용하는 경우, 사용자가 항상 카메라의 시야에 있어야 한다. 이는 사용자에게 불편함과 사생활 문제를 야기할 수 있다. 반면, IMU 센서만을 사용하여 정보를 수집할 경우 복잡한 동작을 인식하기 어렵다[

11].

따라서 본 연구에서는 IMU 센서와 거리 센서를 결합하여 사용자의 정확한 활동 인식과 실시간 위치 추적이 동시에 가능한 방법을 개발하였다. UWB 센서를 이용한 측위를 통해 사용자의 위치 변화를 높은 정확도로 추적하고, 이 데이터를 IMU 센서의 시계열 데이터와 통합하여 활동 인식의 정확도를 높였다. IMU 센서에는 쿼터니언 특징을 추가하여 특히 회전 동작의 분류 정확도를 향상시켰다. 또한 HAR에 적합한 5개의 딥러닝 모델을 평가하여 가장 성능이 우수한 모델을 선정하기 위해 각 활동에 대한 정확도를 분석하였다.

2. 관련 연구

대규모 데이터 세트가 있더라도 IMU가 제공하는 가속도, 자이로 데이터만으로는 전환 동작을 정확하게 구분하기 어렵다. 이러한 한계를 해결하기 위해 일부 연구에서는 정확도를 높이기 위해 여러 IMU 센서를 사용하거나 심전도 [

12,

13]와 같은 추가 센서를 추가하였다. 여러 개의 IMU 센서를 사용하면 더 넓은 범위의 행동을 분류할 수 있지만, 사용자가 일상 생활에서 착용하기에는 실용적이지 않다. 특히 단기간이 아닌 며칠 또는 몇 주 등 장기간에 걸쳐 노인이나 환자를 모니터링할 때는 착용하는 센서의 수를 최소화하여 불편함을 줄이는 것이 중요하다. 센서가 적으면서도 높은 정확도를 달성하려면 모델이 특정 행동에 대해 명확하게 정의된 특징을 식별하는 것이 필요하다. 자이로스코프는 회전 속도에 관한 정보만을 제공하지만 쿼터니언은 각도에 대한 특징 정보를 제공한다. 쿼터니언 정보를 통해 회전 동작을 더 명확하게 감지할 수 있다. 정확한 쿼터니언 정보를 얻으려면 기존 데이터 세트에서 거의 제공되지 않는 자력계 값이 추가로 필요하다. 따라서 쿼터니언 기능을 수동으로 추출하여 추가하였다. 위치 정보를 수집하기 위해서는 UWB를 이용하였다. UWB기반의 측위 시스템은 센티미터 단위까지 정확도가 높다는 장점이 있어 실내 위치 측위에 주로 사용되고 있다[

14].

본 연구에서는 기존의 가속도, 각속도(자이로), 중력 특징에 쿼터니언 특징을 추가하고 임계값 사용과 같은 전통적인 기법 대신 딥러닝 모델을 바탕으로 데이터를 학습하였다.

랜덤 포레스트[

15]와 같은 머신러닝 방법과 달리 딥러닝은 시계열 및 주파수 성분에서 평균과 최대값과 같은 값을 직접 추출하고 처리하지 않으며 정확도가 상대적으로 높기 때문에 최근 HAR 분야에서 주로 사용된다. 시계열 데이터 처리에는 일반적으로 순환신경망(RNN) 기법이 사용된다[

16]. Mekruksavanich 등은 로컬 및 글로벌 특징을 모두 추출하기 위해 1D CNN과 LSTM을 결합한 높은 정확도의 방법을 제안하였다[

17,

18]. Li 등은 Bi-LSTM 기법을 사용하여 다양한 HAR 데이터 세트에서 97% 이상의 높은 정확도를 달성하였다[

19]. Sarkar 등은 연속 변환 웨이블릿 함수로 시계열과 주파수 값을 분석하기 위해 CNN 모델을 활용하였다. 또한 주의 메커니즘을 통해 중요한 특징을 추출하는 방법을 도입하여 이미지 특징 추출에서 CNN의 강점[

20]을 활용하였다.

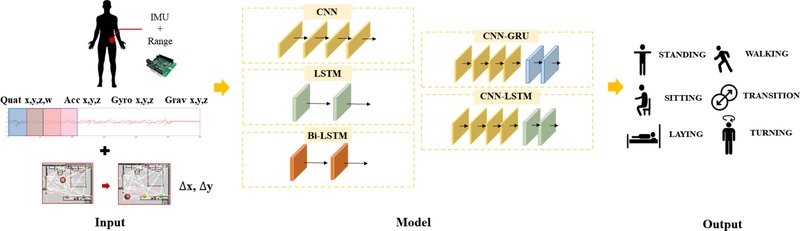

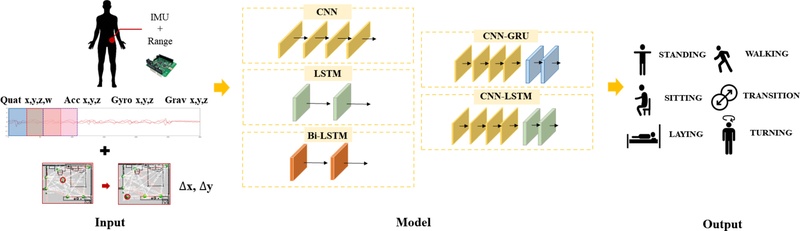

3. 실험 환경

Fig. 2는 센서 데이터 수집부터 분류하는 과정을 거치는 전체 시스템을 보여준다. 허리에 부착된 1개의 센서가 IMU와 거리 데이터를 동시에 수집하고, 이 데이터는 실시간으로 PC로 전송된다. 데이터는 5가지 딥러닝 모델을 통해 분류하였다.

Fig. 2 Overall system of activity recognition

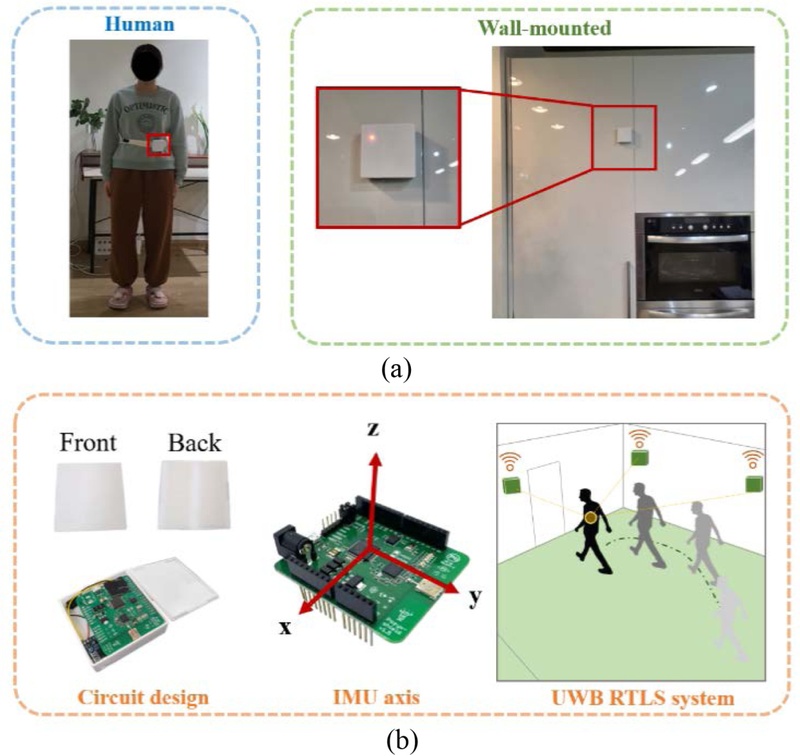

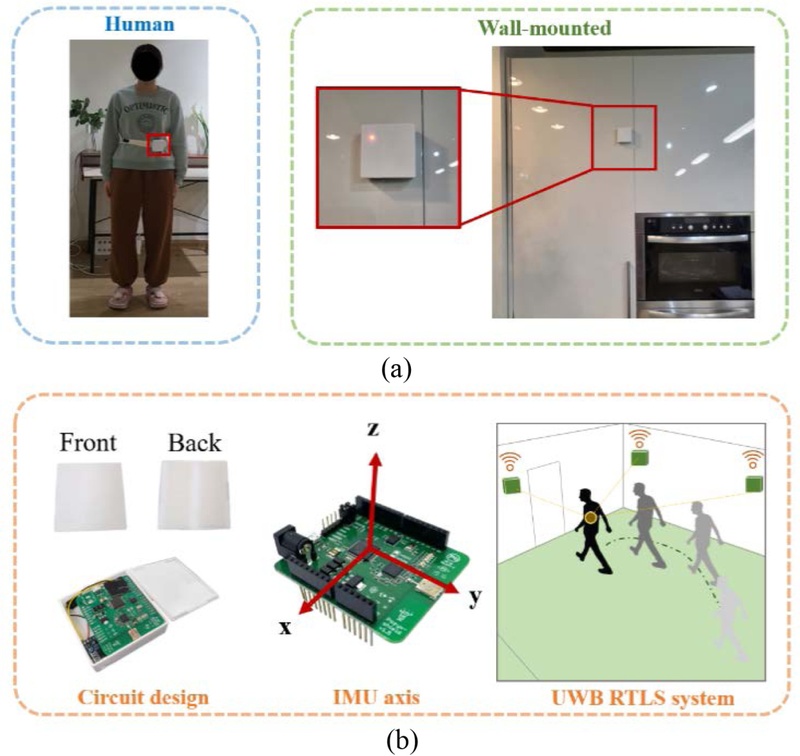

3.1 웨어러블 및 부착형 센서

위치 측위에는 Wifi, BLE등의 센서를 사용하는 것이 가능하나, 본 연구에서는 정확도가 상대적으로 높은 UWB 기반 센서를 사용하였다. Pozyx의 UWB 센서[

21]를 사용하였고, 이를 배터리와 충전 회로가 내장된 케이스에 내장하였다. 센서는 벨크로 테이프로 원하는 위치에 쉽게 탈부착할 수 있으며, 크기가 65 × 65 × 20 mm

3로 다양한 장소에 착용하거나 부착하는 것이 용이하다.

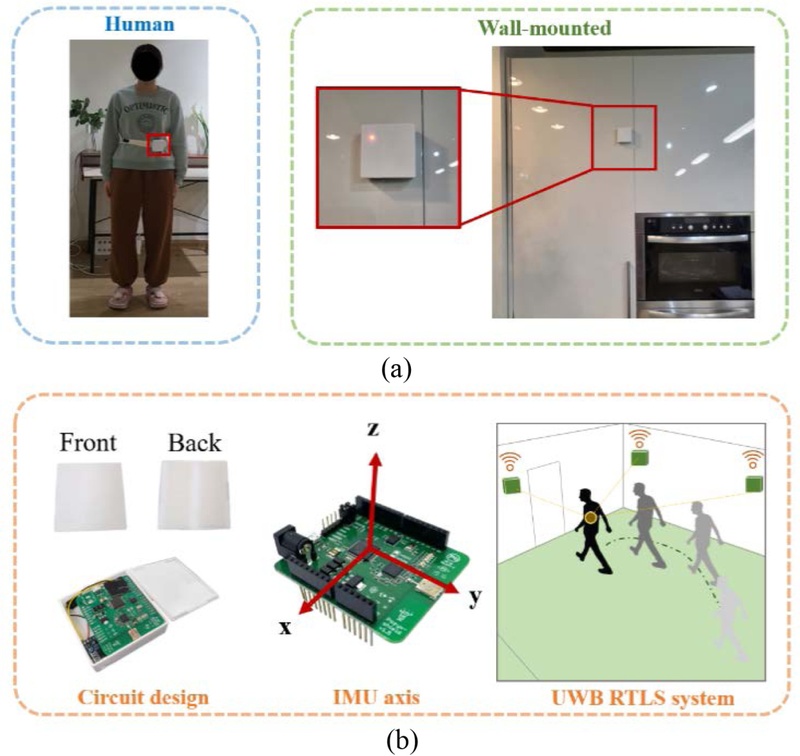

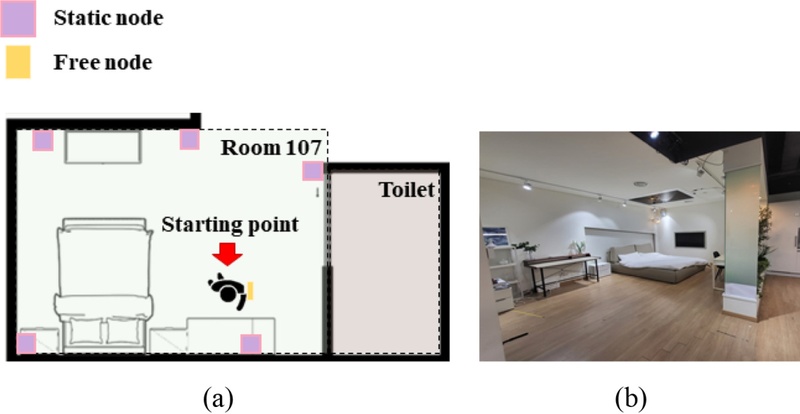

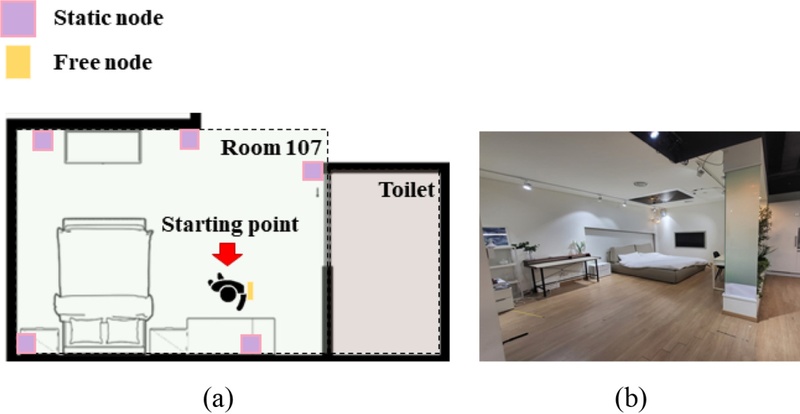

Figs. 3(a)는 사람과 벽에 센서를 부착한 모습이고, 3(b)는 IMU 센서의 기준 축 방향과 거리 데이터 수집 과정을 보여준다. 거리 데이터 수집은 UWB 통신을 이용한다. 실험은

Fig. 5에 표시된 "Living Lab" 107호실과 욕실에서 진행되었으며 실험 공간에 배치된 센서 5개와 PC에 연결된 센서 1개, 전체 공간에 총 6개의 센서를 사용하였다.

Fig. 3Sensor attachment environments and features. (a) Sensors attached to a person and walls and (b) Reference axis orientation of sensor and UWB system

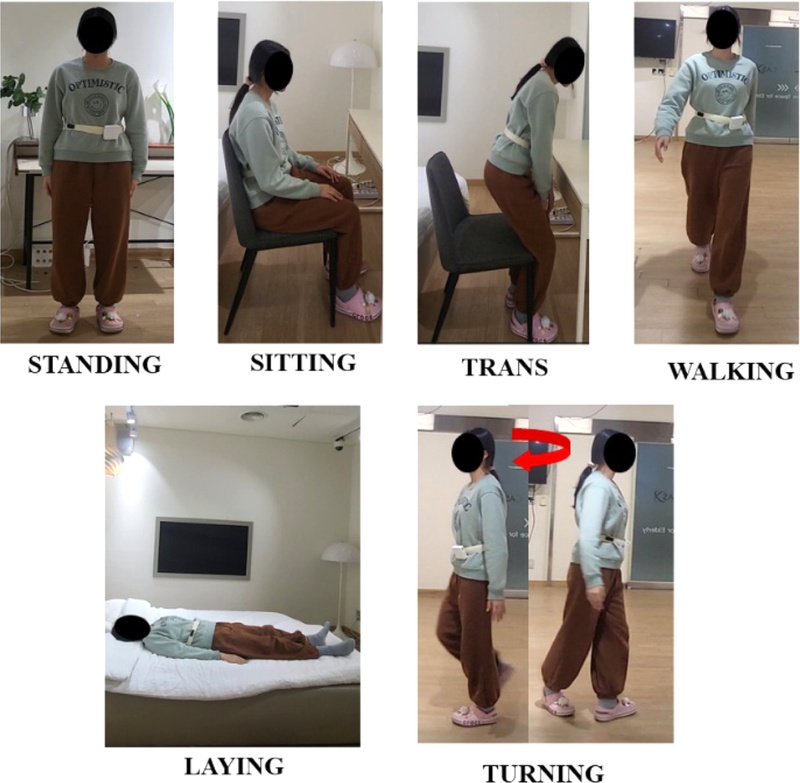

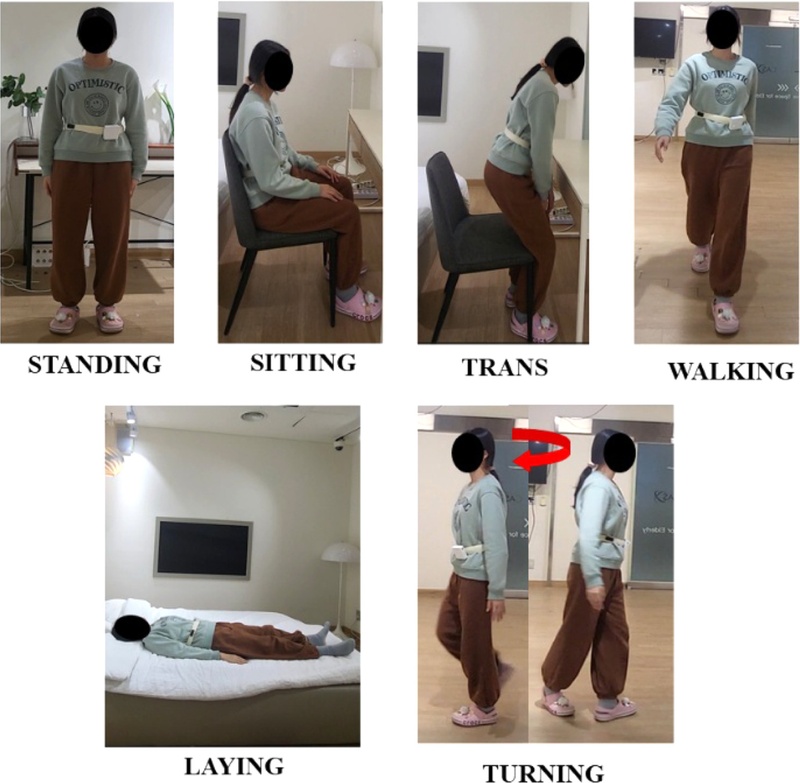

3.2 HAR 데이터 수집

본 연구의 실험은 보건복지부 지정 공공기관 생명윤리심의위원회(KIST-202209-HR-023)의 승인을 받아 진행되었다. 데이터 수집은 건강한 4명의 여성 참가자(나이: 25.75±3.9세, 키: 1.63±0.03 m, 몸무게: 54.2±3.0 kg), 3명의 남성 참가자 (나이: 29±2.6세, 키: 1.74±0.01 m, 몸무게: 76.8±7.1 kg) 각각에 대해 주어진 시나리오를 세 번씩 실행하는 방식으로 진행되었다. 각 행동을 개별적으로 수집하는 대신, 전체 시나리오 내에서 여러 행동을 혼합하여 한 번에 수집하였다.

Fig. 4는 데이터 수집을 위해 지시한 행동을 나타낸다. 시나리오 1회 반복당 약 2분 정도 소요되었으며, 네 가지 일상 행동을 구성하는 서기, 걷기, 앉기, 눕기와 앉았다 일어서는 동작, 누웠다 일어서는 동작 전환, 걷다가 갑자기 방향을 바꾸는 등의 방향 전환 총 두 가지 행동을 포함하였다. 참가자들은 시나리오 내내 주어진 동작들을 반복적으로 수행하였다. 시나리오 과정은 다음과 같이 진행되었다:

Fig. 5의 "Living Lab" 다이어그램에 표시된 시작 지점에서부터 참가자들은 15초 동안 앉고, 서고, 누워 있는 모든 정적인 동작을 한 번에 15초간 유지하였다. 걷기, 전환 및 회전 동작은 시나리오 중에 자연스럽게 발생하므로, 동작 지시 없이 라벨을 붙였다. 다양한 상황에서의 행동을 수집하기 위해 참가자들은 의자에 앉거나, 침대에 누워 있거나, 화장실에 들어가 앉도록 지시하여 각 행동에 대한 여러 상황의 데이터를 수집할 수 있도록 하였다. 실험은 비디오로 녹화하여 데이터에 수동으로 라벨을 붙였다.

Fig. 4Recognized daily living and fall risk activities

Fig. 5(a) “Living Lab” room diagram and (b) Real room

3.3 데이터 전처리

수집된 데이터는 적절한 데이터셋으로 변환하기 위해 전처리 과정을 거쳤다. IMU 데이터는 100 Hz, RTLS 데이터는 20 Hz의 속도로 수집되었기 때문에 동일한 시간 내에 수신되는 데이터의 양이 다르다. 주파수를 일치시키기 위해 IMU 데이터는 50 Hz로 다운샘플링하고, 위치 정보는 선형 보간을 통해 50 Hz로 업샘플링하였다. 그 후 IMU와 위치 정보를 조기 융합하여 중력을 제거한 가속도, 자이로, 중력, 쿼터니언, 위치 변화량(이전 위치와 현재 위치의 x방향과 y방향 차이) 총 15가지 특징을 추출하였다. 각 데이터 세트는 128개 배치로 구성되었으며, 슬라이딩 윈도우 기법[

22]을 사용하여 50%의 중첩을 적용하였다. 수집된 데이터 내 각 행동의 분포는

Table 1에 요약되어 있다. 처리한 데이터는 5배 교차 검증을 실시하여 훈련, 검증, 테스트 세트를 각각 6 : 2 : 2의 비율로 나누어 행동 분류를 위한 모델을 학습시켰다.

Table 1Activity details of dataset

Table 1

|

Activity |

Description |

Class distribution [in %] |

|

STANDING |

The participant did nothing and remained still |

31.26 |

|

WALKING |

The participant moved in a straight line at a speed of 4-5 km/h |

30.28 |

|

SITTING |

The participant was seated in a chair |

16.44 |

|

LAYING |

The participant did nothing but lay still on a bed |

9.00 |

|

TRANS |

The participant is switching action to another |

6.52 |

|

TURNING |

The participant is changing moving direction |

6.69 |

4. 제안 프레임워크

이 섹션에서는 처리된 데이터를 학습하는 데 적합한 5가지 딥러닝 모델의 특징과 선택된 파라미터에 대해 설명한다.

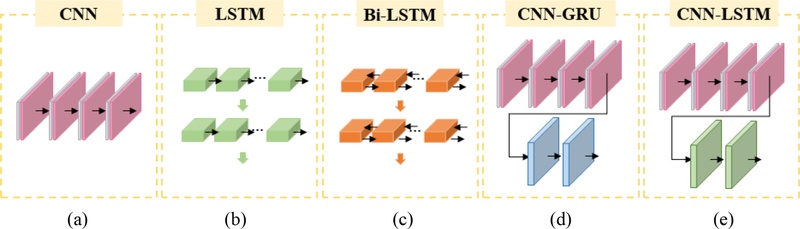

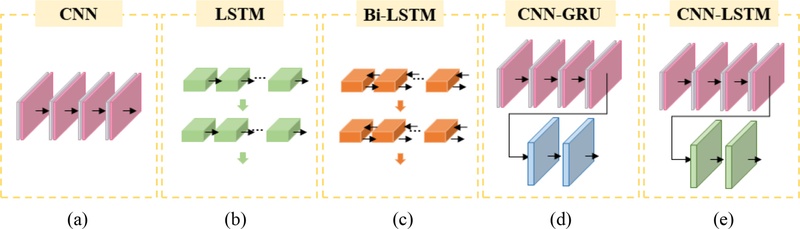

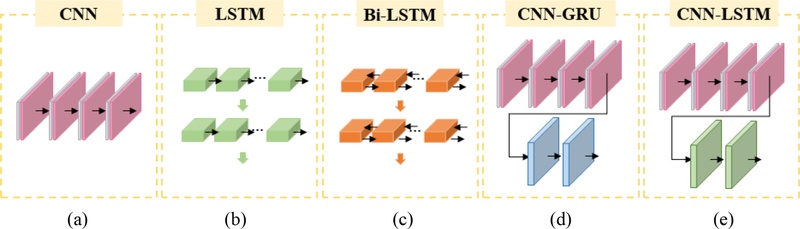

그림 6은 제안하는 모델들의 구조를 보여준다.

Fig. 6 Structure of deep learning models. (a) CNN, (b) LSTM, (c) Bi-LSTM, (d) CNN-GRU and (e) CNN-LSTM

4.1 컨볼루션 신경망

컨볼루션 신경망(CNN)은 데이터에 내재된 공간적 상관관계를 추출하고 분류하는 데 탁월하며, 특히 고차원 데이터 세트에서 학습하는 데 적합하다. HAR 또는 시계열 데이터를 처리하기 위해 일반적으로 1D CNN이 사용되며, 본 연구에서도 사용되었다.

Fig. 6(a)에 표시된 것처럼 4개의 레이어를 가진 CNN(CNN-4L)을 구현하였다. 이 모델은 15개의 특징과 128개의 타임스텝으로 구성된 입력 데이터를 처리하며, 4개의 레이어를 순차적으로 통과한다. 각 레이어에는 크기가 2인 최대 풀링이 통합되어 데이터를 다운샘플링하고 50% 드롭아웃 레이어를 포함함으로써 과적합을 완화하였다. 레이어 탐색 후에는 데이터를 평탄화하여 분류를 위해 차원을 변경한다. 그런 다음 완전 연결 계층과 소프트맥스 활성화 함수를 적용하여 6개의 최종 분류 값을 출력하였다.

장단기 기억(LSTM) 모델은 언어와 같이 시계열 또는 긴 순차 데이터를 학습하는 데 일반적으로 적용되며, 기존의 순환신경망(RNN)보다 발전한 모델이다. 본 연구에서는

Fig. 6(b)에 표시된 2계층 LSTM 모델(LSTM-2L)을 사용하였다. 각 층은 128개의 유닛으로 구성되며, 과적합을 억제하기 위해 드롭아웃 층이 50%로 설정되어 있다. 이 모델은 두 레이어를 통과한 후 완전 연결 계층을 통과하고 소프트맥스 활성화를 거쳐 분류 결과를 출력하였다.

양방향 장단기 메모리(Bi-LSTM)는 LSTM의 구조를 반영하지만, 정보를 정방향과 역방향 모두에서 추출한다. 양방향으로 정보를 추출하여 일방적인 정보 추출의 한계를 극복한 모델이다.

Fig. 6(c)에서 Bi-LSTM-2L로 표시된 Bi-LSTM 모델은 총 128개의 유닛을 가진 두 개의 레이어로 구성되며, LSTM-2L와 동일한 구성을 사용하였다. 각 레이어는 드롭아웃 레이어를 50%로 설정하였다. 고밀도 레이어를 거쳐 소프트맥스 활성화로 분류되어 분류 결과를 출력하였다.

본 연구에 사용된 CNN-GRU 모델의 구조는

Fig. 6(d)에서 확인할 수 있다. 최대 풀링 및 드롭아웃 레이어가 각각 뒤따르는 4개의 1D-CNN 레이어의 출력은 2개의 GRU 레이어에 공급되며, 각 GRU 레이어는 128개의 유닛으로 구성된다. 6개의 레이어를 모두 통과한 데이터는 1차원으로 평탄화되고 완전 연결 계층을 통해 처리된 후 드롭아웃 및 소프트맥스 레이어를 거쳐 행동 분류를 위한 6개의 출력 뉴런이 생성된다.

CNN과 LSTM을 결합하여 시간적 특징과 공간적 특징을 모두 추출하기 위해 널리 사용되는 모델이다. 이 모델은 시계열 및 적외선 이미지와 같이 시간적, 공간적 이해가 모두 필요한 데이터를 분석하는 데 강점을 보인다. 이 접근 방식에서는 CNN이 먼저 공간 및 국소적 특징을 추출한 다음 LSTM 계층을 통과하여 시간적 및 전역 패턴을 학습한다.

Fig. 6(e)에 표시된 것처럼 4개의 1D-CNN 레이어와 2개의 LSTM 레이어를 결합한 모델을 활용하였다. 이 아키텍처는 각 레이어가 128개의 유닛으로 구성된 CNN-GRU 모델로 구성되었다. 마지막으로, 데이터는 평탄화-완전연결계층-소프트맥스 레이어를 통해 처리되어 행동 분류를 위한 6개의 출력을 생성한다.

5. 평가 결과

수집된 데이터를 사용하여 제안한 모델들을 훈련하고 실험을 진행하였다. 실험 후 성능 평가를 통해 수집한 데이터 셋에 가장 적합한 모델을 결정하였다. 특징 추출을 위해 각 모델을 초기화하고 무작위 가중치로 학습시켰다. 최적화 도구로는 Adam을 사용했으며, 에포크는 각각 100개, 배치 크기는 64개로 설정하였다. 모델 간 비교의 신뢰도를 높이기 위해 각 모델당 학습을 총 5회 시행하여 평균을 도출하였다. 통계적 유의성 검정을 위해 Paired t-test를 수행하였으며, 그 결과 모델 간 성능 차이는 p < 0.001로 유의미함을 확인하였다. 또한 정확도, 정밀도, 리콜, F1 점수, 혼동 행렬을 사용하여 성능을 평가하고 각 모델을 검증하였다.

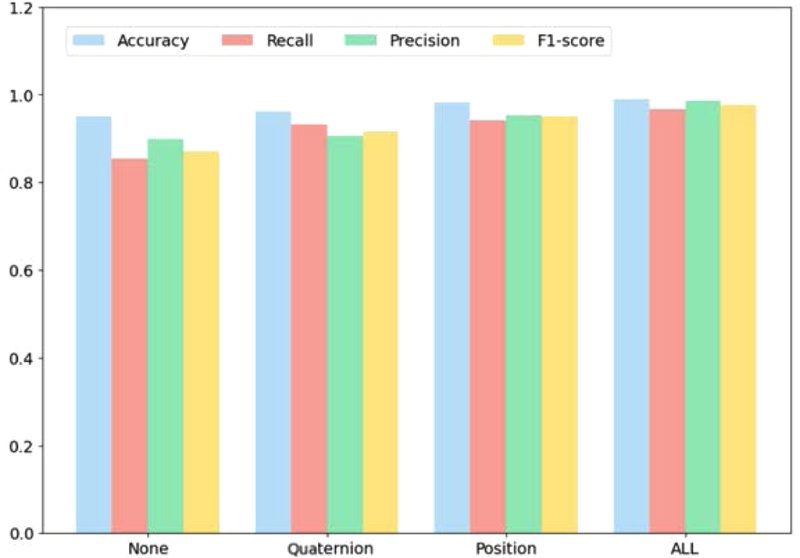

이 때, 융합된 센서와 파라미터의 효과를 별도로 평가하기 위해 IMU의 쿼터니언 기능과 위치 정보 융합 없이 학습된 모델, 이 두 가지 기능 중 하나로 학습된 모델, 모든 기능을 결합하여 학습된 모델 간의 평균 정확도를 비교하였다.

Table 2에 정확도 비교 결과를 요약하였다. 9가지 특징(가속도, 자이로, 중력)만을 활용했을 때 LSTM-2L 모델이 평균 91.15%로 가장 낮은 정확도를 보인 반면, CNN-LSTM 모델은 평균 95.05%로 가장 높은 정확도를 보였다. 특히, 데이터가 시계열임에도 불구하고 1D CNN 모델의 정확도가 LSTM 모델을 능가한 것은 수집한 데이터의 내재적 특징이 시간적 순서보다 더 중요한 의미를 갖는다는 것을 의미한다. 쿼터니언 특징을 포함시켜 총 13개의 특징을 학습에 사용한 결과, 모든 모델이 평균 약 1%의 정확도 향상을 보였다. 특히, LSTM 기반 모델의 정확도가 CNN 기반 모델에 비해 더 큰 정확도 향상을 보였다. 또한 쿼터니언 특징 없이 위치 데이터를 융합하여 총 11개의 특징으로 학습했을 때 정확도 증가율은 쿼터니언 특징만을 추가하여 학습했을 때를 능가했으며, 이 경우 CNN 기반 모델이 더 큰 정확도 증가를 보였다. 행동 인식에서 위치 데이터를 융합하는 것이 효과적이었으며, 이는 쿼터니언 특징만을 활용하는 것보다 동작 정보와 위치 정보의 조합을 활용하는 것이 걷기 등의 동적 행동과 전환 동작 행동을 구별하는 데 더 효과적이라는 것을 의미한다.

Table 2 Accuracy comparison of deep learning models

Table 2

|

Feature |

CNN-4L [%] |

LSTM-2L [%] |

Bi-LSTM-2L [%] |

CNN-GRU [%] |

CNN-LSTM [%] |

|

Conventional IMU feature |

94.79 |

91.15 |

92.97 |

95.05 |

95.05 |

|

Add quaternion |

95.31 |

92.45 |

94.27 |

95.31 |

96.09 |

|

Add position |

97.40 |

92.97 |

95.83 |

97.14 |

98.18 |

|

Add all |

98.18 |

95.83 |

97.92 |

97.66 |

98.96 |

모든 모델에서 위치 특징과 쿼터니언 특징을 동시에 추가할 때 평균 정확도 증가율은 3-4%로 가장 높은 정확도 증가율을 보였다. 특히 두 가지 다른 아키텍처를 결합한 모델이 여러 레이어를 사용하는 단일 모델에 비해 더 높은 정확도를 보였다. 5가지 모델 중 모든 기능을 통합했을 때 가장 높은 정확도를 보인 모델은 CNN-LSTM이었다. 모든 기능을 통합했을 때 가장 높은 정확도를 보여 행동 정확도 분석에 최적화된 모델로 선정하였다.

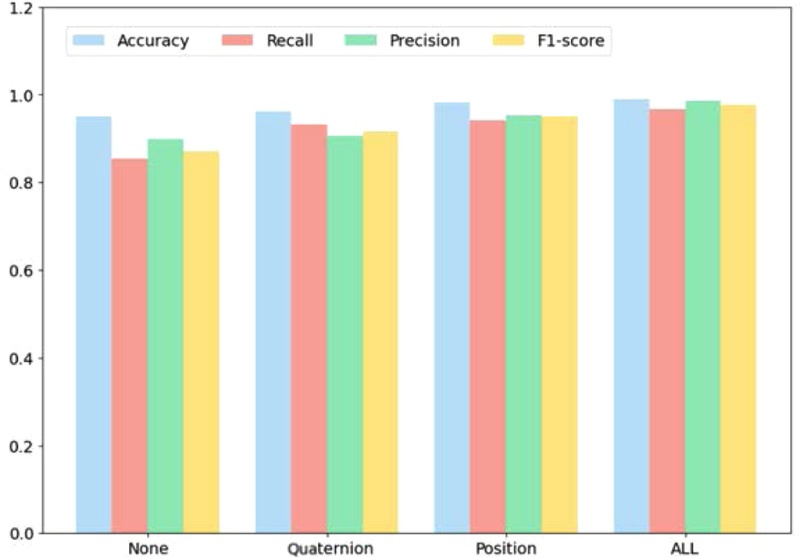

Fig. 7은 본 연구에서 제안한 특징들을 CNN-LSTM 모델을 이용해 정확도, 정밀도, 재현율, F1 점수 값을 비교한 것으로, 모든 지표에서 쿼터니언과 위치를 추가했을 때 가장 우수한 성능을 보였음을 알 수 있다.

Fig. 7 Accuracy Comparison by features

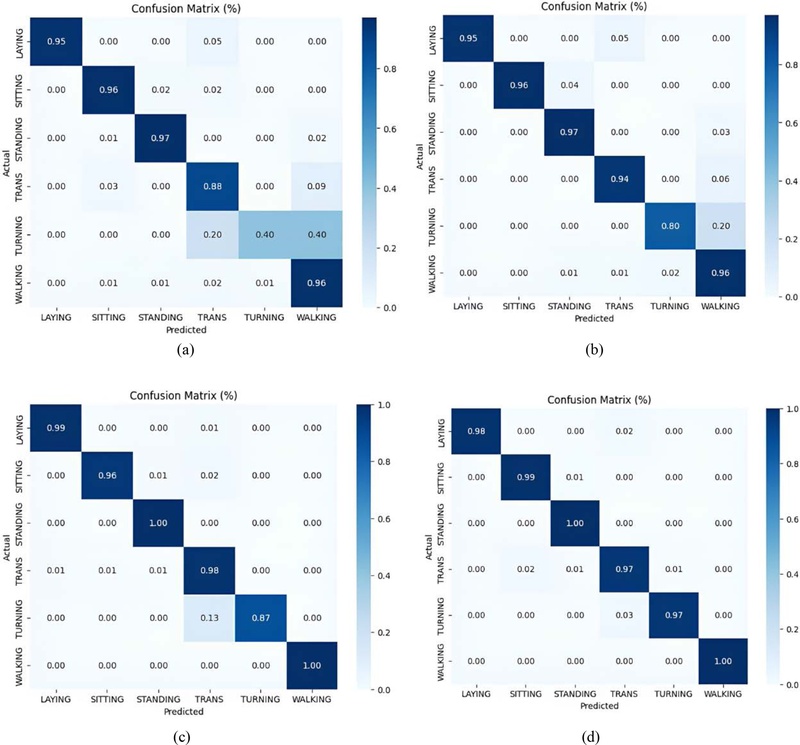

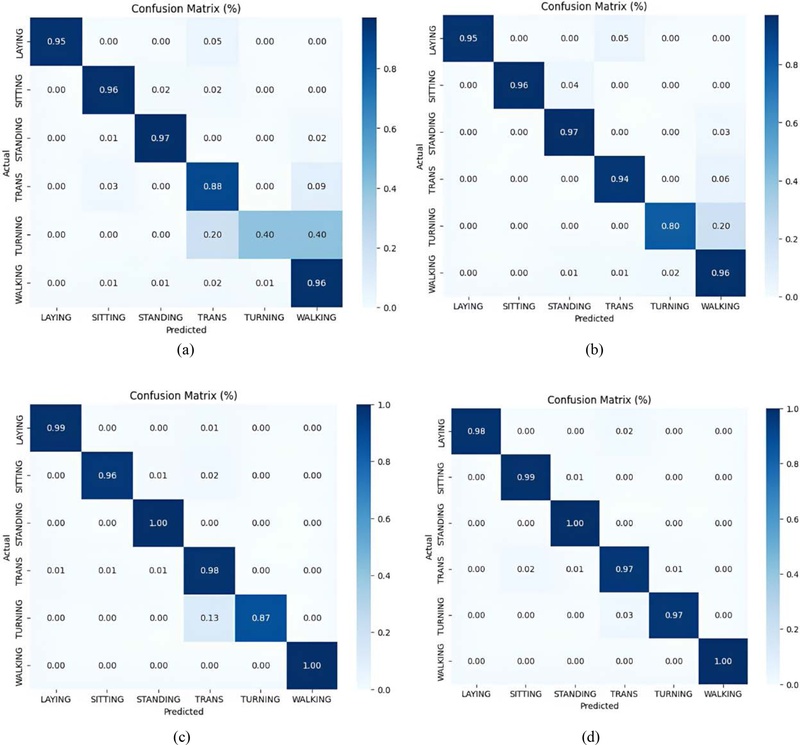

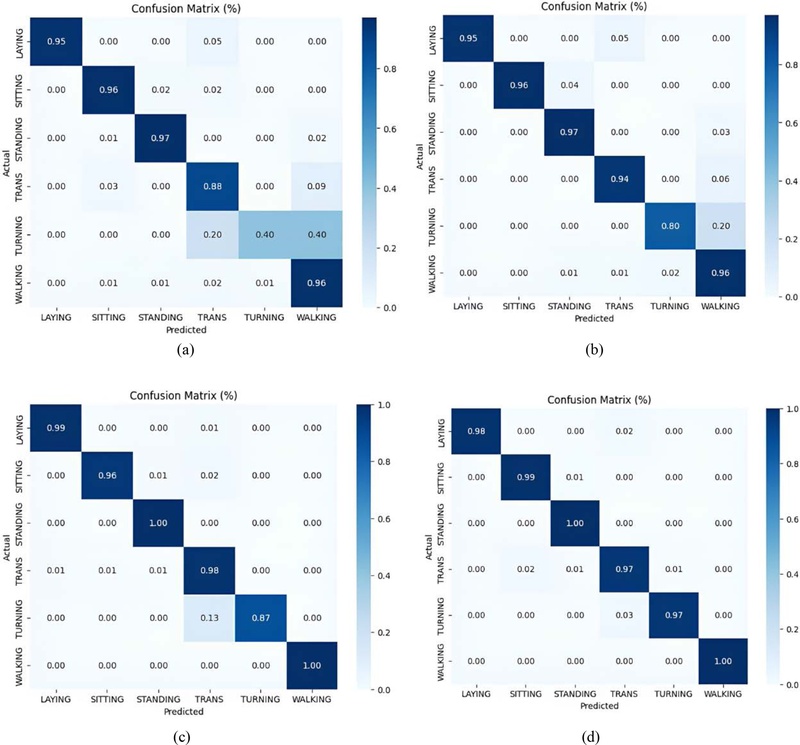

Fig. 8은 테스트 데이터로 CNN-LSTM을 사용하여 학습한 최종 모델의 분류 동작을 특징 변화에 따라 히트 맵으로 나타낸 것이다.

Fig. 8(a)에는 9개의 특징을 사용하여 CNN-LSTM으로 훈련된 모델을 적용한 결과가 나와 있다. 세 가지 정적인 행동(서기, 앉기, 눕기)는 99-100%의 정확도로 분류되는 반면, 동작 전환과 방향 전환은 걷기와 같은 동적인 행동으로 잘못 식별되는 것을 알 수 있다. 특히 회전이 40%로 가장 낮은 정확도를 보였다.

Fig. 8(b)는 4개의 쿼터니언 특징을 통합한 학습 결과를 보여주는데, 각도 데이터를 포함하면 실험자의 회전 동작을 예측하는 정확도가 40%에서 80%로 약 두 배 증가하였다. 이는 쿼터니언 특징이 회전 동작을 변별하는데 효과적이라는 것을 의미한다. 이어서

Fig. 8(c)는 위치 특징만을 통합하여 학습 및 분류한 결과를 보였으며, 실시간 위치 데이터를 활용할 경우 전환 동작과 혼동하는 경우가 있으나 회전 동작의 정확도가 87%까지 증가하여 회전과 보행 동작을 보다 명확하게 분류하는 것이 가능하였다. 마지막으로

Fig. 8(d)는 쿼터니언과 위치 특징을 동시에 활용하여 얻은 결과를 보인다.

Fig. 8(a)와 비교했을 때, 정적 동작의 정확도를 떨어뜨리지 않으면서도 전환, 회전 두 가지 동적 동작을 97% 이상의 높은 정확도로 분류할 수 있었다.

Fig. 8 Confusion matrices on the CNN-LSTM model. (a) No Quaternion and position feature, (b) Quaternion feature, (c) Position feature, and (d) Quaternion and position feature

6. 결론

본 연구는 일상 활동, 특히 기존에 다루지 않았던 동작 전환 및 방향 전환 행동 분류 정확도를 향상시키는 방법을 제시하였다. 동작과 위치 특징을 결합하여 회전 및 전환 동작 검출 정확도를 크게 개선하였으며, 두 가지 유형 모두 97%의 정확도를 달성하였다. 그러나 7명의 참가자를 대상으로 실험을 수행하여 표본 크기가 제한적이었으므로, 모델의 일반화 가능성에는 제약이 있다. 이를 극복하기 위해 향후 연구에서는 참가자 수를 늘리고, 데이터 증강·합성 데이터를 활용하는 등 실험 설계를 보완하여 과적합 위험을 줄이고 모델의 신뢰성을 강화할 필요가 있다.

또한 본 연구는 건강한 성인을 대상으로 한 실험이라는 한계가 있으므로, 노약자 및 낙상 고위험군을 포함한 대상자를 추가 모집하여 실제 임상 환경에서의 적용 가능성을 평가하는 것이 바람직하다. 나아가 본 행동 인식 기술을 로봇이나 모니터링 기기에 통합하면, 의료진이 부재인 상황에서도 자동으로 응급 대응을 지원하는 서비스 구현 등이 기대된다. 이러한 확장 연구를 통해 본 기술이 환자 및 노약자의 안전 관리를 효과적으로 돕는 실질적 솔루션으로 발전할 수 있을 것으로 예상된다.

ACKNOWLEDGMENTS

본 연구는 행정안전부(No. 2001446) 이 지원하는 감염병연구개발사업(GFID)과 한국과학기술연구원 기관고유사업(No. 2E33002) 및 보건복지부의 재원으로 한국보건산업진흥원의 보건의료기술연구개발사업 지원에 의하여 이루어진 것임(No. RS-2022-KH129657).

REFERENCES

- 1.

Park, D., Hoshi, Y., Mahajan, H. P., Kim, H. K., Erickson, Z., Rogers, W. A., Kemp, C. C., (2020), Active robot-assisted feeding with a general-purpose mobile manipulator: Design, evaluation, and lessons learned, Robotics and Autonomous Systems, 124, 103344.

10.1016/j.robot.2019.103344

- 2.

Louie, W.-Y. G., McColl, D., Nejat, G., (2012), Playing a memory game with a socially assistive robot: A case study at a long-term care facility, Proceedings of the 2012 IEEE RO-MAN: The 21st IEEE International Symposium on Robot and Human Interactive Communication, 345-350.

10.1109/ROMAN.2012.6343777

- 3.

Kwon, Y., Shin, S., Yang, K., Park, S., Shin, S., Jeon, H., Kim, K., Yun, G., Park, S., Byun, J., (2023), Heterogeneous robot-assisted services in isolation wards: A system development and usability study, Proceedings of the 2023 IEEE/RSJ International Conference on Intelligent Robots and Systems, 8069-8076.

10.1109/IROS55552.2023.10341857

- 4.

Arpan, I., Shah, V. V., McNames, J., Harker, G., Carlson-Kuhta, P., Spain, R., El-Gohary, M., Mancini, M., Horak, F. B., (2022), Fall prediction based on instrumented measures of gait and turning in daily life in people with multiple sclerosis, Sensors, 22(16), 5940.

10.3390/s22165940

- 5.

Almajid, R., Goel, R., Tucker, C., Keshner, E., (2020), Balance confidence and turning behavior as a measure of fall risk, Gait & Posture, 80, 1-6.

10.1016/j.gaitpost.2020.05.020

- 6.

Pozaic, T., Lindemann, U., Grebe, A.-K., Stork, W., (2016), Sit-to-stand transition reveals acute fall risk in activities of daily living, IEEE Journal of Translational Engineering in Health and Medicine, 4, 1-11.

10.1109/JTEHM.2016.2620177

- 7.

Rapp, K., Becker, C., Cameron, I. D., König, H.-H., Büchele, G., (2012), Epidemiology of falls in residential aged care: Analysis of more than 70,000 falls from residents of bavarian nursing homes, Journal of the American Medical Directors Association, 13(2), 187.

10.1016/j.jamda.2011.06.011

- 8.

Danielli Coelho de Morais Faria, C., Fuscaldi Teixeira-Salmela, L., Nadeau, S., (2009), Effects of the direction of turning on the timed up & go test with stroke subjects, Topics in Stroke Rehabilitation, 16(3), 196-206.

10.1310/tsr1603-196

- 9.

Thu, N. T. H., Han, D. S., (2021), Hihar: A hierarchical hybrid deep learning architecture for wearable sensor-based human activity recognition, IEEE Access, 9, 145271-145281.

10.1109/ACCESS.2021.3122298

- 10.

Thu, N. T. H., Han, D. S., (2020), Utilization of postural transitions in sensor-based human activity recognition, Proceedings of the 2020 International Conference on Artificial Intelligence in Information and Communication, 177-181.

10.1109/ICAIIC48513.2020.9065250

- 11.

Steven Eyobu, O., Han, D. S., (2018), Feature representation and data augmentation for human activity classification based on wearable imu sensor data using a deep lstm neural network, Sensors, 18(9), 2892.

10.3390/s18092892

- 12.

Chavarriaga, R., Sagha, H., Calatroni, A., Digumarti, S. T., Tröster, G., Millán, J. d. R., Roggen, D., (2013), The opportunity challenge: A benchmark database for on-body sensor-based activity recognition, Pattern Recognition Letters, 34(15), 2033-2042.

10.1016/j.patrec.2012.12.014

- 13.

Pecchia, L., Chen, L., Nugent, C., Bravo, J., (2014), Ambient assisted living and daily activities: 6th international work-conference, iwaal 2014, belfast, UK, December 2-5, 2014, proceedings, Springer.

10.1007/978-3-319-13105-4

- 14.

Kim, J.-H., Kim, D., (2020), Computationally efficient cooperative dynamic range-only slam based on sum of gaussian filter, Sensors, 20(11), 3306.

10.3390/s20113306

- 15.

Dewi, C., Chen, R.-C., (2019), Human activity recognition based on evolution of features selection and random forest, Proceedings of the 2019 IEEE International Conference on Systems, Man and Cybernetics, 2496-2501.

10.1109/SMC.2019.8913868

- 16.

Zebin, T., Sperrin, M., Peek, N., Casson, A. J., (2018), Human activity recognition from inertial sensor time-series using batch normalized deep LSTM recurrent networks, Proceedings of the 2018 40th Annual International Conference of the IEEE Engineering in Medicine and Biology Society, 1-4.

10.1109/EMBC.2018.8513115

- 17.

Perez-Gamboa, S., Sun, Q., Zhang, Y., (2021), Improved sensor based human activity recognition via hybrid convolutional and recurrent neural networks, Proceedings of the 2021 IEEE International Symposium on Inertial Sensors and Systems, 1-4.

10.1109/INERTIAL51137.2021.9430460

- 18.

Mekruksavanich, S., Jitpattanakul, A., (2020), Smartwatch-based human activity recognition using hybrid LSTM network, 2020 IEEE Sensors, 1-4.

10.1109/SENSORS47125.2020.9278630

- 19.

Li, Y., Wang, L., (2022), Human activity recognition based on residual network and BiLSTM, Sensors, 22(2), 635.

10.3390/s22020635

- 20.

Sarkar, A., Hossain, S. S., Sarkar, R., (2023), Human activity recognition from sensor data using spatial attention-aided CNN with genetic algorithm, Neural Computing and Applications, 35(7), 5165-5191.

10.1007/s00521-022-07911-0

- 21.

- 22.

Ortiz Laguna, J., Olaya, A. G., Borrajo, D., (2011), A dynamic sliding window approach for activity recognition, Proceedings of the User Modeling, Adaption and Personalization: 19th International Conference, 219-230.

10.1007/978-3-642-22362-4_19

Biography

- Hayeon Kim

Received the master’s degree from the Department of Mechanical Engineering, Ulsan National Institue of Technology, Korea in 2023. Her research interest is robotics.

- Yoonseob Lim

Received the B.S. in Mechanical Engineering and the M.S. in Electrical Engineering from Seoul National University, Seoul, South Korea in 2002 and 2004, respectively. He received the Ph.D degree in Computational Neuroscience from Boston University, Boston, MA, USA in 2014. He is currently a Senior Researcher at Korea Institute of Science and Technology, Seoul, South Korea and an institute adjunct professor with the Department of HY-KIST Bio-Convergence, Hanyang University, Seoul, South Korea. His research interest includes human-robot interaction, knowledge representation, auditory neuroscience, and neural decoding.

- Doik Kim

Received the B.S., M.S., and Ph.D. degree in Mechanical Engineering from the POSTECH, Pohang, Korea, in 1995, 1997, and 2002, respectively. He is currently a principal researcher of Center for Intelligent and Interactive Robotics Research, Korea Institute of Science and Technology (KIST) in Seoul, Korea. His current research interests are in the fields of software architecture for robot motion and interaction, multi-robot interactive cooperation, and human-robot teaming based on the distributed sensor system.